Google hat gerade eine vielversprechende neue Funktion für die Google Search Console angekündigt: die Möglichkeit, Daten direkt nach BigQuery zu exportieren. Wir haben keine Zeit verschwendet und die Exportfunktion vor drei Tagen aktiviert. Bei unserer ersten Analyse konnten wir eine Fülle zusätzlicher URL- und Keyword-Daten aufdecken, die in den Standardberichten der Search Console bisher nicht verfügbar waren. Mit der neuen BigQuery-Exportfunktion kannst du jetzt noch tiefere Einblicke in die Leistung deiner Website gewinnen, die dir vorher möglicherweise verborgen geblieben sind.

2.330% mehr verschiedene Keywords im BigQuery-Export

Wir haben die Daten von zwei Websites analysiert – von einer Kleinen und einer Großen. Wir haben einen signifikanten Unterschied in der Anzahl der verschiedenen URLs und Keywords für die große Website festgestellt, mit standardmäßig 5.000 über die API und 160.515 verschiedenen Keywords im BigQuery-Export.

Wir haben nur einen Tag verglichen, um vergleichbare Daten für einen täglichen Export zu haben.

| Search Console Frontend Export* | Search Console API* | BigQuery Export | |

|---|---|---|---|

| Anzahl der verschiedenen URLs: Kleine Website | 119 | 119 | 119 |

| Anzahl der verschiedenen URLs: Große Website | 1000 | 5000 | 19.212 |

| Anzahl der verschiedenen Keywords: Kleine Website | 1000 | 1437 | 1437 |

| Anzahl der verschiedenen Keywords: Große Website | 1000 | 5000 | 160.515 |

| Anzahl der verschiedenen Keywords die das Wort X enthalten: Kleine Website | 203 | 203 | 203 |

| Anzahl der verschiedenen Keywords die das Wort X enthalten: Große Website | 13 | 13 | 661 |

Wie du in der Tabelle sehen kannst, erhalten große Websites viel mehr Daten von Google. Aber auch kleine Websites mit mehr als 5k verschiedenen Keywords können von den Vorteilen des Exports profitieren.

Insbesondere die Tatsache, dass die Anzahl der eindeutigen Keywords, die ein bestimmtes Wort enthalten, bei der großen Website viel höher ist, zeigt, dass die Datenmenge, die im GSC gespeichert wird, im Vergleich zum Export begrenzt ist.

*Durch das Filtern von Daten, das Anlegen weiterer Eigenschaften usw. ist es möglich, mehr Zeilen zu erhalten, aber es muss eingerichtet werden und du kannst nie sicher sein, dass du alle Daten herausbekommst.

Viele One Impression Keywords (an diesem Tag)

88% der Keywords für die große Website hatten nur eine Impression und nur 7% hatten einen oder mehrere Klicks an diesem Tag. Wir erwarten jedoch, dass wir über einen längeren Zeitraum mehr Keywords mit Klicks und Impressionen sehen werden.

Täglicher Daten-Export

Es ist wichtig zu wissen, dass der Datenexport am Tag der Aktivierung beginnt und die Daten jeden Tag exportiert werden. Ein Backfill der Daten findet nicht statt.

Datenfelder in den Exportdaten

Die exportierten Daten enthalten Felder wie Datum, Land, Suchtyp usw., ähnlich wie die Abfragefelder in der Google Search Console, einschließlich aller Filter, um nach dem Erscheinungsbild der Suche zu filtern. Die Datentabellen werden im BigQuery-Datensatz erstellt. Da die Daten in einem Tabellenformat miteinander kombiniert werden, lassen sich die Daten leichter mit Diagrammen, Pivot-Tabellen usw. analysieren.

Hier findest du die vollständigen Tabellenrichtlinien und Referenzen.

Erste Schritte für den Export von Daten nach BigQuery

Ein paar Worte vorab: Bevor wir uns mit dem Export von Google Search Console-Daten über BigQuery befassen, ist es wichtig zu wissen, dass die Kosten für die Datenspeicherung und Abfrage in der Google Cloud Platform mit der Zeit ansteigen können. Um unerwartete Kosten zu vermeiden, empfiehlt es sich, das Preismodell von Google Cloud Platform zu kennen und deine Nutzung und Kosten regelmäßig zu überprüfen. Es ist auch hilfreich, sich vor dem Start einen allgemeinen Überblick über die Google Cloud Platform zu verschaffen.

Für jede Property, die du in BigQuery exportierst, empfiehlt es sich ggf., ein eigenes Projekt in Google Cloud Platform zu erstellen. Es ist nicht möglich, den zugewiesenen Dataset-Namen zu ändern und zwei GSC-Properties in dasselbe Projekt zu exportieren, was bedeutet, dass die Daten aus diesen Properties in dieselbe Tabelle geschrieben werden. Es kann sinnvoll sein, beiden Properties denselben Zugriff zu gewähren, aber wenn du eine detailliertere Zugriffskontrolle möchtest, empfehlen wir dir, zwei Projekte zu erstellen.

Kommen wir nun zu der Schritt-für-Schritt-Anleitung für den Export deiner Search Console-Daten.

1.

Aktiviere BigQuery in deinem Google Cloud-Projekt

Navigiere zu APIs & Dienste > Aktivierte APIs & Dienste in der Seitenleiste der Google Cloud Console. Wenn BigQuery nicht aktiviert ist, klicke auf + APIS UND DIENSTE AKTIVIEREN, um die BigQuery-API zu aktivieren. Oder klicke einfach hier.

2.

Gewähre der Search Console Zugriff auf dein Google Cloud-Projekt

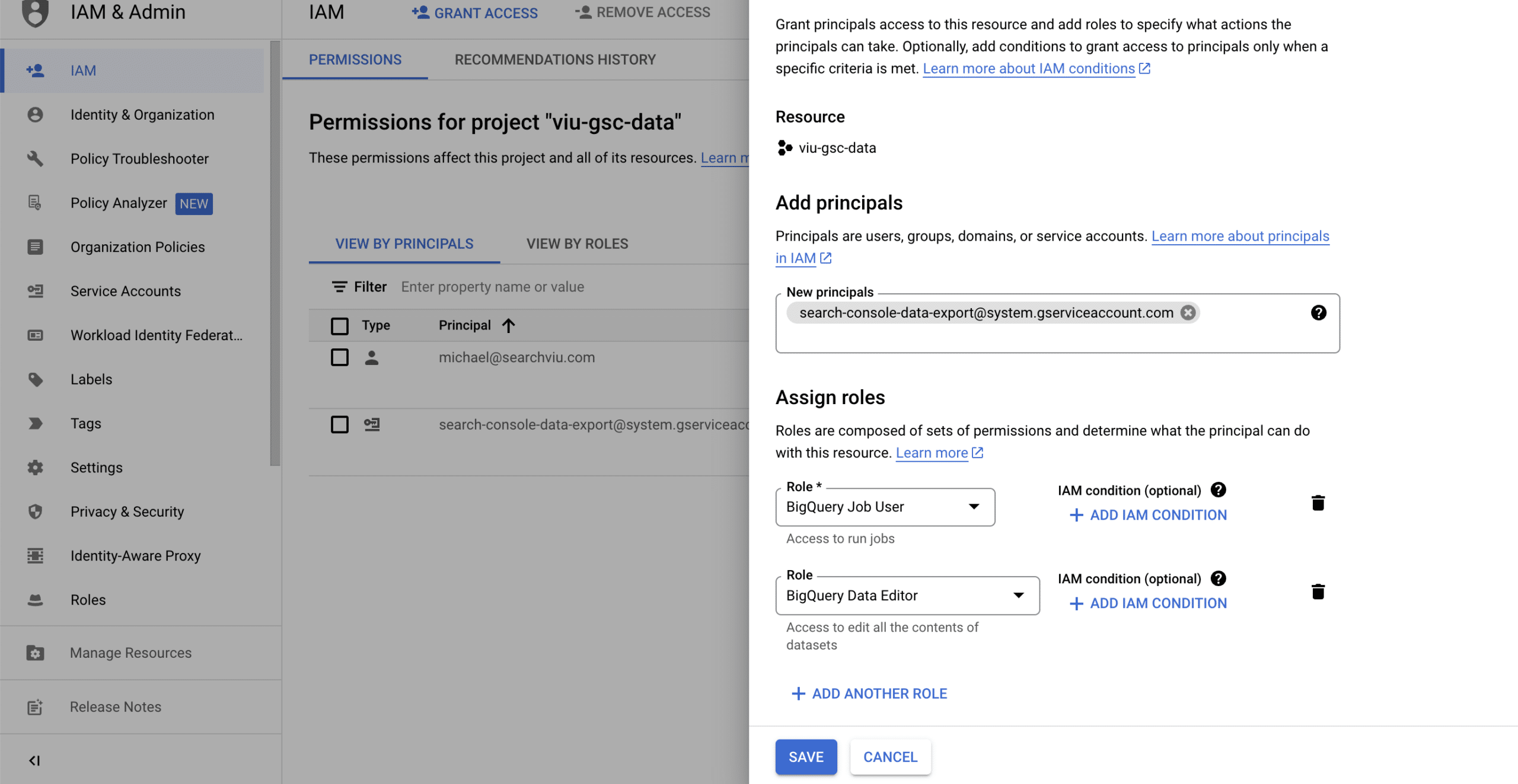

Navigiere zu IAM und Admin in der Seitenleiste der Google Cloud Console. Oder klicke hier.

Klicke auf + GRANT ACCESS, um ein Seitenfenster mit der Aufschrift „Add Principals“ zu öffnen. Füge unter „New Principals“ das folgende Dienstkonto ein:

search-console-data-export@system.gserviceaccount.com

Erteile ihm zwei Rollen: BigQuery Job User & BigQuery Data Editor

3.

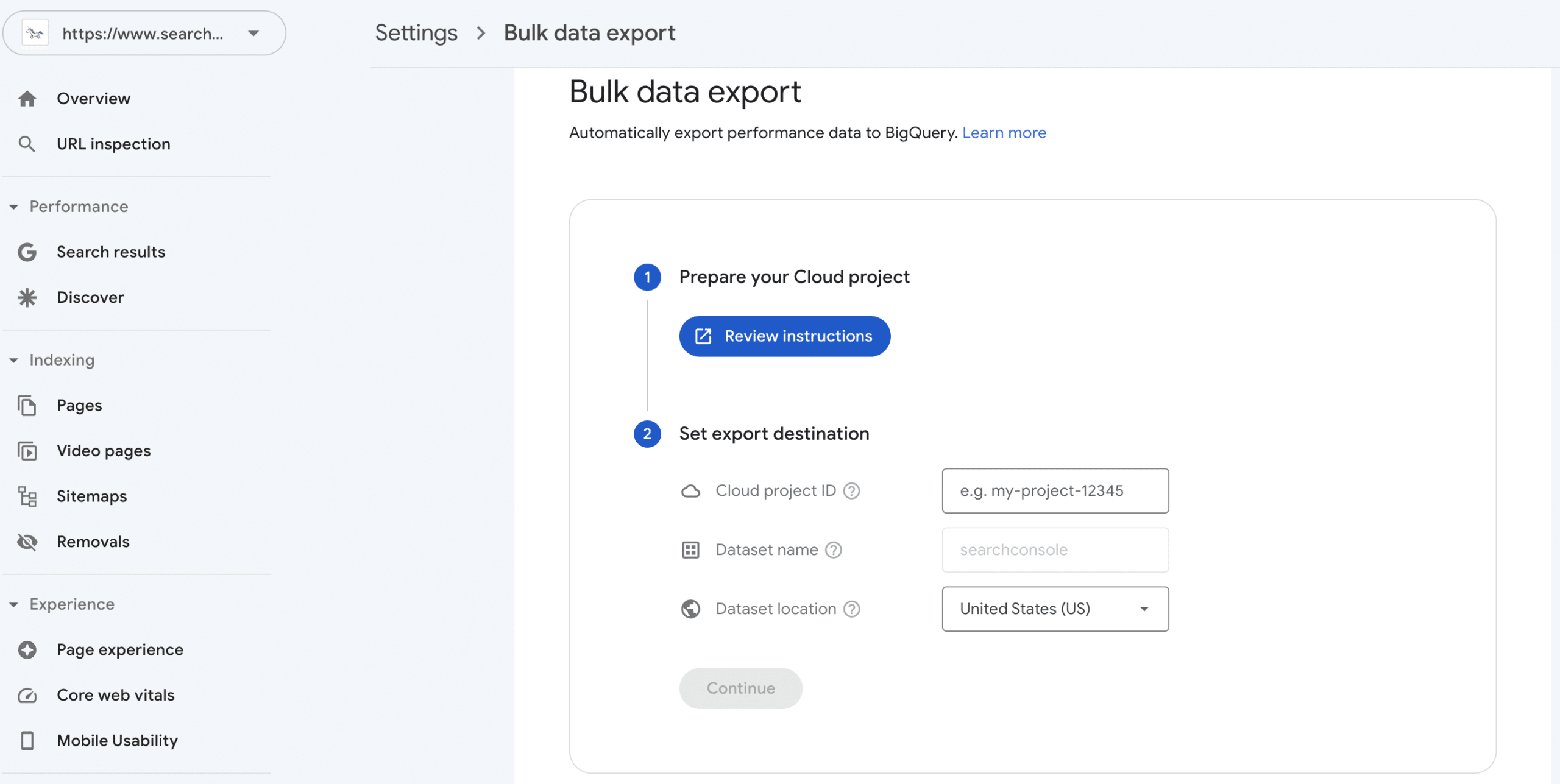

Richte dein Google Cloud-Projekt in der Search Console ein

Gehe in der Search Console zu Einstellungen > Bulk data export für dein Projekt. Kopiere die Projekt-ID (den Namen des Google Cloud-Projekts, das du erstellt hast) in das Feld Cloud-Projekt-ID.

Wähle einen Speicherort für deinen Datensatz aus der Liste und klicke auf Weiter.

Danach dauert es ein oder zwei Tage, bis die ersten Daten in BigQuery ankommen.

Wenn du diese Schritte befolgst, kannst du die Daten der Google Search Console über tägliche Bulk-Exporte nach BigQuery exportieren.

Weitere Informationen über die Einrichtung des Exports findest du in diesen Artikeln von Google:

https://support.google.com/webmasters/answer/12917675

https://developers.google.com/search/blog/2023/02/bulk-data-export

Zugang zu den Daten

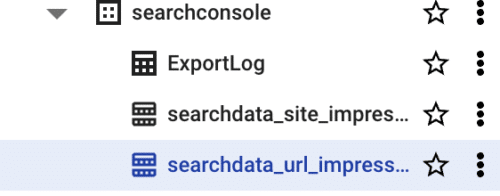

Nachdem die ersten Daten in BigQuery importiert wurden, kannst du einige SQL-Anweisungen erstellen, um die Daten zu untersuchen. Es ist aber viel einfacher, die Daten direkt mit Google Looker Studio zu untersuchen. Navigiere dazu zu Google Cloud Plattform -> BigQuery und wähle das Dataset und eine Tabelle aus.

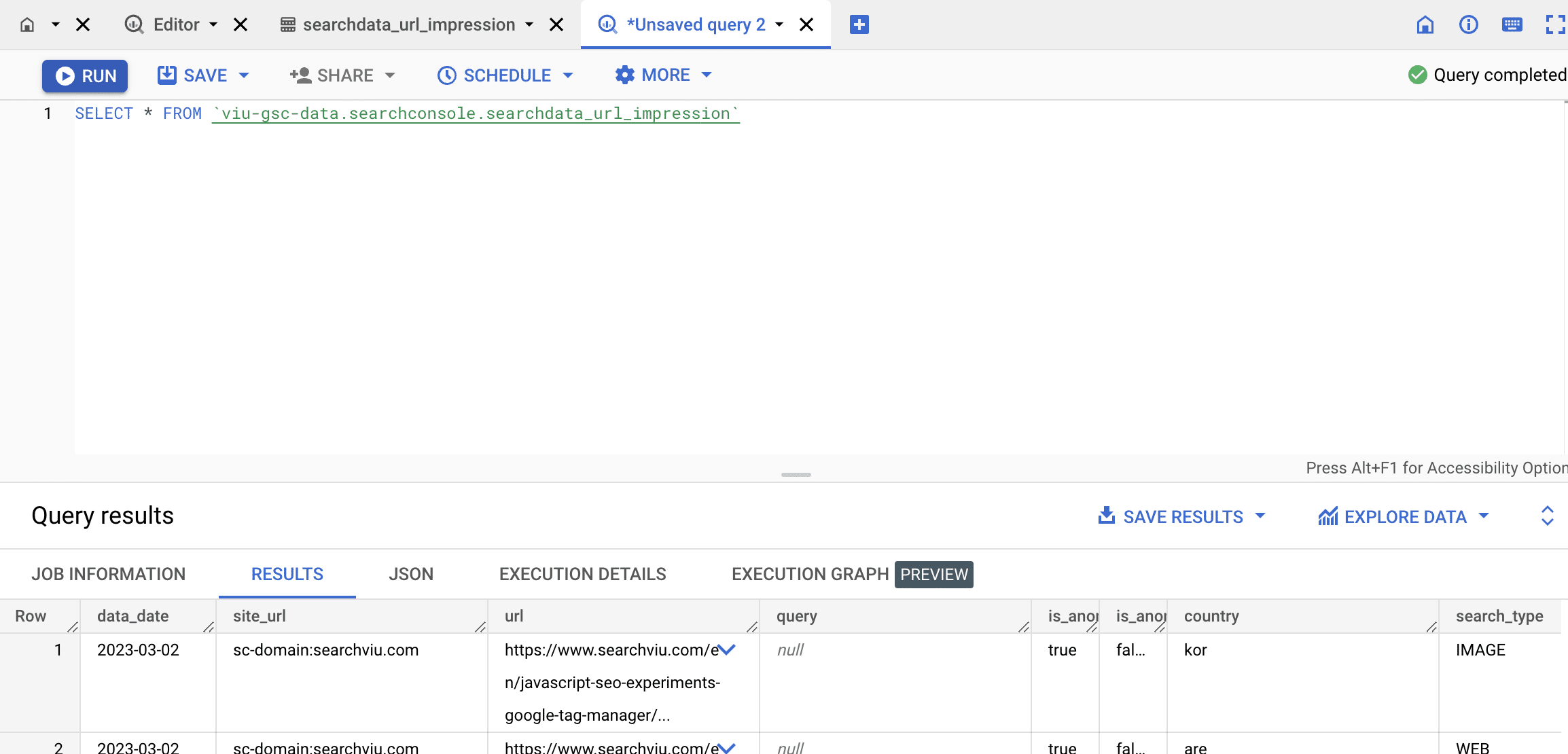

Klicke auf Abfrage (Query) und ändere die Abfrage in:

SELECT * FROM `{deinProjekt}.searchconsole.searchdata_url_impression`

(damit werden alle Spalten der Tabelle über den gesamten Zeitraum abgefragt)

Führe die Abfrage aus.

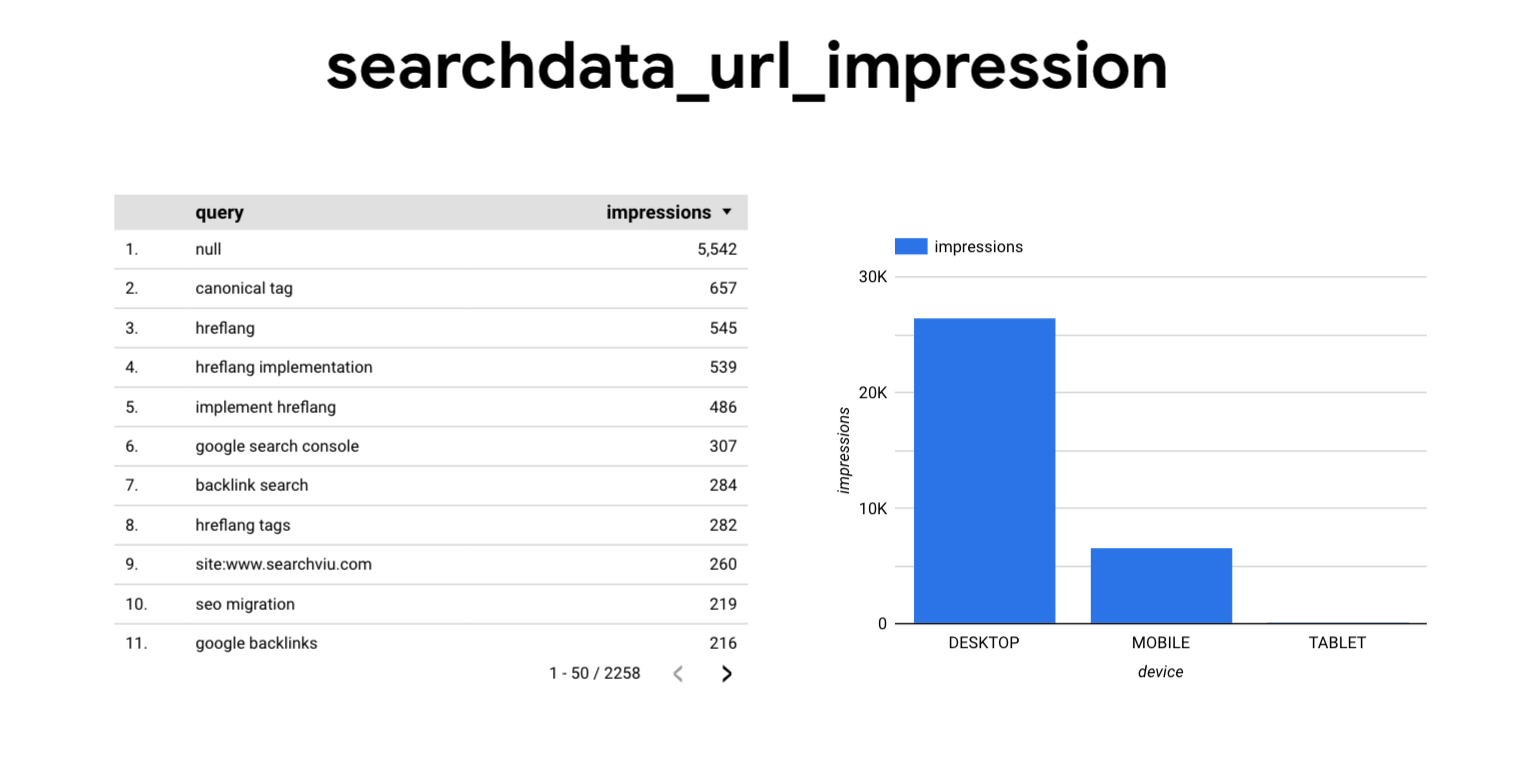

Klicke auf Explore Data -> Explore with Looker Studio.

Hier kannst du die Daten untersuchen, ohne eine zusätzliche SQL-Abfrage zu schreiben.

Zusammenfassung

Der erweiterte Export von GSC-Daten nach BigQuery gibt weitaus mehr Einblicke, aber auch eine größere Menge an Daten, die verwaltet und analysiert werden müssen. Wegen des täglichen Exports empfehlen wir, so bald wie möglich damit anzufangen – denn jeden Tag, an dem die Funktion noch nicht aktiviert ist, verlierst du Daten.

Wenn du an einem Daten-Warehouse-Service interessiert bist, der sich um alle Dinge rund um deinen Daten-Export kümmert, zögere nicht damit, uns zu kontaktieren.